本篇文章给大家谈谈搜索引擎关键词快速优化,以及关键词搜索引擎又称为对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

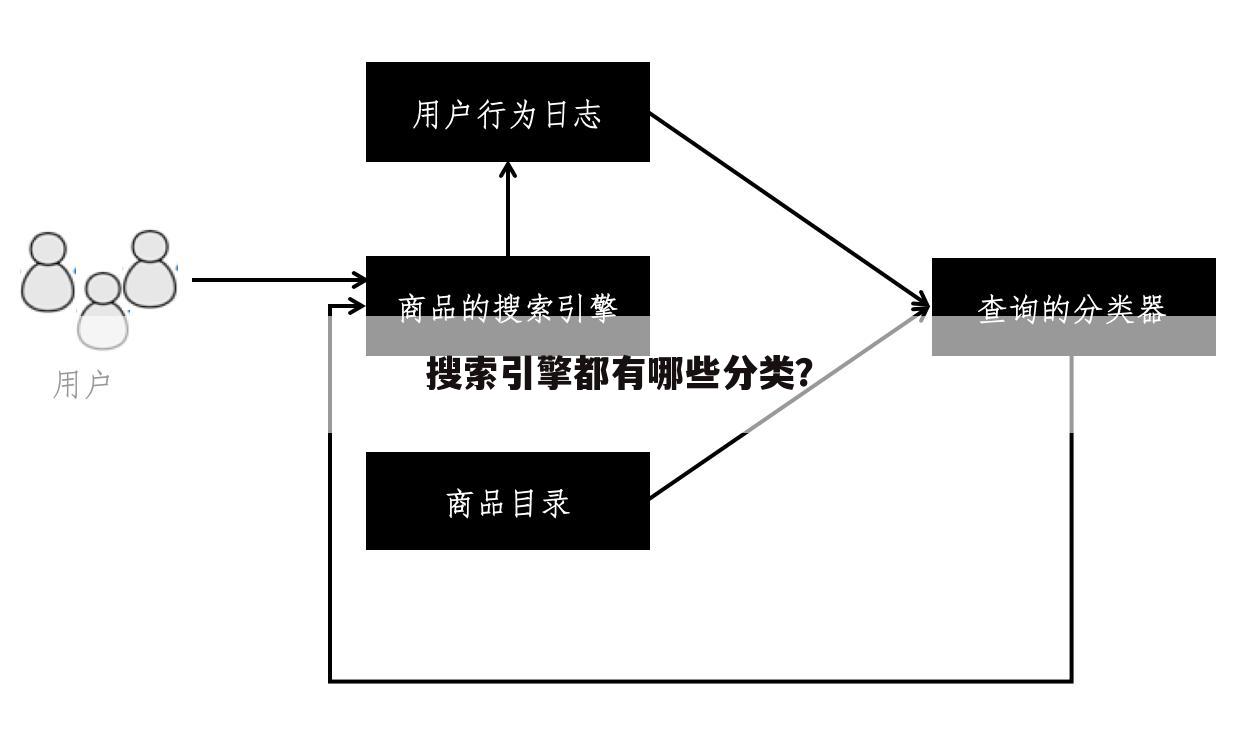

搜索引擎都有哪些分类?

本文贡献者:【舊夢舊惆怅】, 疑问关键字:搜索引擎关键词快速优化, 下面就让重庆云诚科技小编为你解答,希望本文能找到您要的答案!

最佳回答【分类】

1.全文索引

全文搜索引擎是名副其实的搜索引擎,国外代表有Google,国内则有著名的百度搜索。它们从互联网提取各个网站的信息(以网页文字为主),建立起数据库,并能检索与用户查询条件相匹配的记录,按一定的排列顺序返回结果。

根据搜索结果来源的不同,全文搜索引擎可分为两类,一类拥有自己的检索程序(Indexer),俗称“蜘蛛”(Spider)程序或“机器人”(Robot)程序,能自建网页数据库,搜索结果直接从自身的数据库中调用,上面提到的Google和百度就属于此类;另一类则是租用其他搜索引擎的数据库,并按自定的格式排列搜索结果,如Lycos搜索引擎。

2.目录索引

目录索引虽然有搜索功能,但严格意义上不能称为真正的搜索引擎,只是按目录分类的网站链接列表而已。用户完全可以按照分类目录找到所需要的信息,不依靠关键词(Keywords)进行查询。目录索引中最具代表性的莫过于大名鼎鼎的Yahoo!、新浪分类目录搜索。

3.元搜索引擎

元搜索引擎(META Search Engine)接受用户查询请求后,同时在多个搜索引擎上搜索,并将结果返回给用户。著名的元搜索引擎有InfoSpace、Dogpile、Vivisimo等,中文元搜索引擎中具代表性的是搜星搜索引擎。在搜索结果排列方面,有的直接按来源排列搜索结果,如Dogpile;有的则按自定的规则将结果重新排列组合,如Vivisimo。

其他非主流搜索引擎形式

(1)集合式搜索引擎:该搜索引擎类似元搜索引擎,区别在于它并非同时调用多个搜索引擎进行搜索,而是由用户从提供的若干搜索引擎中选择,如HotBot在2002年底推出的搜索引擎。

(2)门户搜索引擎:AOL Search、MSN Search等虽然提供搜索服务,但自身既没有分类目录也没有网页数据库,其搜索结果完全来自其他搜索引擎。

(3)免费链接列表(Free For All Links,简称FFA):一般只简单地滚动链接条目,少部分有简单的分类目录,不过规模要比Yahoo!等目录索引小很多。

【工作原理】

1、抓取网页

每个独立的搜索引擎都有自己的网页抓取程序(spider)。Spider顺着网页中的超链接,连续地抓取网页。由于互联网中超链接的应用很普遍,理论上,从一定范围的网页出发,就能搜集到绝大多数的网页。

2、处理网页

搜索引擎抓到网页后,还要做大量的预处理工作,才能提供检索服务。其中,最重要的就是提取关键词,建立索引文件。其他还包括去除重复网页、分析超链接、计算网页的重要度。

3、提供检索服务

用户输入关键词进行检索,搜索引擎从索引数据库中找到匹配该关键词的网页;为了用户便于判断,除了网页标题和URL外,还会提供一段来自网页的摘要以及其他信息。

以上就是重庆云诚科技小编解答(舊夢舊惆怅)解答关于“搜索引擎都有哪些分类?”的答案,接下来继续为你详解体育用户(抹不掉丶残留记忆)分析“什么叫搜索引擎?为什么叫引擎?”的一些相关解答,希望能解决你的问题!

什么叫搜索引擎?为什么叫引擎?

本文贡献者:【抹不掉丶残留记忆】, 疑问关键字:搜索引擎关键词快速优化, 下面就让重庆云诚科技小编为你解答,希望本文能找到您要的答案!

最佳回答一、什么叫搜索引擎?

在Internet上有上百亿可用的公共Web页面,即使是最狂热的冲浪者也不会访问到所有的页面,而只能看到其中的一小部分,更不会在这浩瀚的Web海洋中发现你那即使精彩却渺小的一隅。当然你可以为你的存在做广告,可以用大大的字把你的URL刻在你的身体上,然后裸体穿过白宫草坪,但你得保证媒体正好在那里,并注视到了这一切。与其这样做,不如好好去理解搜索引擎是如何工作的?又怎样选择和使用"keywords"(关键词)等等。

本文的目的就是让众多的页面设计者在了解搜索引擎的基础上,寻求如何使自己的页面在搜索引擎索返回的列表中获得好的排列层次的方法。

"搜索引擎"这个术语一般统指真正意义上的搜索引擎(也就是全文检索搜索引擎)和目录(即目录式分类搜索引擎),其实他们是不一样的,其区别主要在于返回的搜索结果列表是如何编排的。

二、搜索引擎是如何工作的?

搜索引擎有三个主要的基本部分。

1、搜索引擎蜘蛛

搜索引擎首先利用的是一种俗称蜘蛛(Spider)或爬虫(Crawler)的软件。搜索引擎蜘蛛访问到一个页面,读取它,然后跟随这个页面链接到这个站点的其他页面,这就是人们所说的站点被套住了或者被爬过了。蜘蛛会按照固定的时间不断的回来访问这个站点,如每月或每两个月,以便查看页面的变化。

2、索引

蜘蛛所找到的每一个页面放入搜索引擎的第二部分--索引。索引也可以说是目录册,就像一本巨大的书,书中包含了蜘蛛所找到的每个Web页的拷贝。如果Web页改变了,这本书当然也会更新。但有时蜘蛛发现了新的Web页和Web页的变化,并不是马上加到索引中去,当中间隔一段时间,就是说一个Web页被爬过了,但却不能被索引,直到这个Web页被加到了索引里才可用于搜索引擎的搜索。

3、分析软件

搜索引擎分析软件是一个搜索引擎的第三部分。这个程序详细审查记录在索引中的成百上亿的Web页,找出与搜索要求相匹配的那些,并按他认为最合适的相关性排列出列表,呈现在冲浪者的面前。

三、搜索引擎如何排列Web页面

用你所喜欢的搜索引擎搜索任何东西,搜索引擎几乎立刻就从他知道的几百万的页面中挑选出与你的主题相匹配的那些,呈现在你的荧屏上。这些网页按一定的顺序排列起来,最相关的排在最前面。

但搜索引擎并不是图书管理员,他没有能力一再地询问有关的问题来更好地定位搜索的目标,也不能依靠智力判断和过去的经验来排列网页,而人可以做到。智能化是发展的方向,但还有一段很长的路要走。

那么搜索引擎是怎样决定相关性的呢?他们依靠一套规则,主要的规则是页面中关键词出现的位置和频率,我们把这称做"位置/频率法"。

1、位置和频率

(1)、位置

如果你到图书馆去寻找有关旅游方面的书,管理员首先会去查找题目中有"旅游"的书籍。搜索引擎也一样,关键词(即"旅游")出现在题目(Title)中的页面比那些Title中不出现关键词的页面更相关。

搜索引擎还会检查关键词是否出现在页面的顶部,如文章标题中或前面的几个段落。他们认为与搜索主题相关的页面在开始都会提到那些词语。

(2)、频率

频率是相关性的另外一个主要因素。搜索引擎会分析页面中关键词相对其他词语所出现的频率,频率越高,就越具相关性。

2、搜索引擎在排列网页时有一定的差异

所有的搜索引擎都有提到的三个基本部分,在一定程度上都符合"位置/频率法",但在具体实施上又有区别,这就是为什么我们用不同的搜索引擎做同样的搜索时会产生不同结果的原因。

首先,有些搜索引擎会比其他搜索引擎索引到更多的Web页面,有些又会比其他引擎更新索引的频率快,所以搜索引擎索引中不可能收集完全一样的Web页面。

其次,出于某种原因,有些搜索引擎也可能给某些Web页面在排列层次上有优先权。如Excite用链接的流行度作为排列网页的一个因素,他知道在索引中哪些页面有许多指向他们的链接,他在排列时就给这些页面小小的奖励,将他们适当提前。这也是合理的,因为在Internet上有越多指向他们的链接,就说明这些页面更被大家看重。

另外,一些混合结构(搜索引擎和目录共存)的搜索引擎可能会把那些目录中已存在的站点的网页靠前,理由是一个站点足够好才能放到目录中,就应该有机会比那些不被列在目录中的站点的网页靠前。

最后要强调的是,许多Web页面设计者错误地认为"Meta tags"是将Web页提到列表前列的秘密,实际上有些搜索引擎会把那些"Meta tags"中有keywords的页面靠前,有些搜索引擎根本就不读"Meta tags"。"Meta tags"是解决问题的一个方面,但并不是什么必需的绝密武器。

四、如何提高Web页面的相关性

搜索引擎的一次搜索会返回成百上千的相关网页,一般情况下首先呈现出来的是10个最相关的页面。

任何站点都想被列在前10位,因为大多数的用户都喜欢从前10位中找到他所要的结果,排在第11位以下就意味着许多人不会访问到你的站点。

下面就来看看如何能使你的网页排在列表前列。

1、选择合适的关键词(Keywords)

大胆地设想别人在搜索引擎的搜索框内正好输入的是你页面的Title中选择的关键词,那该多好啊!例如,如果你有一个有关邮票收藏的网页,如果你想别人任何时候在搜索框里输入"邮票收藏"时你能排在前10位,那么就为这个页面选择"邮票收藏"这个关键词吧!

网站的每一个页面都应该有反映网页内容的关键词,并且关键词至少由2个的字或词组成。通常与单个的字或词相关的网站太多太多,例如"邮票"就比"邮票收藏"所相关的网页多得多,那么竞争就激烈,网页排在前列的概率就相对低一些。所以不要怕花费时间,尽量选择2个的字或词组成的短语,成功的可能性会大得多。

最后,假设适当地扩展文章的涉及范围,多选几个关键词又会怎么样呢?例如,一个邮票收藏的网页可能会提到"收藏家"和"收藏",那么扩展开来,用"邮票收藏家"和"邮票收藏"增加关键词的数量也是合理的。可不是没有问题,因为你的网页实际上是关于邮票收藏的精典网页,应该出现在邮票收藏一类网页的前列,但你在关键词上扩展了页面的涉及范围,可能就会无意识地降低页面对于"邮票收藏"的相关性。如何决定更好,看你的想法了!

2、关键词(Keywords)出现的位置

选择好关键词后还要确保关键词出现在至关重要的位置。首先页面的题目(Title)是最重要的地方,忽略将关键词放进页面的题目中是许多本身具备良好相关性的网页被排在底层的原因。

其次像前面提到的,搜索引擎也看中关键词出现在页面前面的网页,所以有可能的话就把关键词作为大标题,并使得关键词出现在网页的第一段。

特别注意的是使用表格会把网页的正文推到网页的更下面,就会造成相关性的降低。例如,画一个有两列的表格,第一列放的是对其他网页的链接,第二列才是含有关键词的正文。浏览看到的网页是这样的:

以上就是重庆云诚科技小编解答(抹不掉丶残留记忆)分析关于“什么叫搜索引擎?为什么叫引擎?”的答案,接下来继续为你详解体育用户(月亮坠入山谷)分析“什么是搜索引擎”的一些相关解答,希望能解决你的问题!

什么是搜索引擎

本文贡献者:【月亮坠入山谷】, 疑问关键字:搜索引擎关键词快速优化, 下面就让重庆云诚科技小编为你解答,希望本文能找到您要的答案!

最佳回答搜索引擎的概念

搜索引擎是指以一定的策略搜集互联网上的信息,在对信息进行组织和处理后,为用户提供检索服务的系统。从使用者的角度看,搜索引擎提供一个包含搜索框的页面,在搜索框输入词语,通过浏览器提交给搜索引擎后,搜索引擎就会返回跟用户输入的内容相关的信息列表。互联网发展早期,以雅虎为代表的网站分类目录查询非常流行。网站分类目录由人工整理维护,精选互联网上的优秀网站,并简要描述,分类放置到不同目录下。用户查询时,通过一层层的点击来查找自己想找的网站。也有人把这种基于目录的检索服务网站成为搜索引擎,但从严格意义上,它并不是搜索引擎。

搜索引擎的工作原理

可以分为三个部分

1、抓取网页

每个独立的搜索引擎都有自己的网页抓取程序(spider)。Spider顺着网页中的超链接,连续地抓取网页。由于互联网中超链接的应用很普遍,理论上,从一定范围的网页出发,就能搜集到绝大多数的网页。

2、处理网页

搜索引擎抓到网页后,还要做大量的预处理工作,才能提供检索服务。其中,最重要的就是提取关键词,建立索引文件。其他还包括去除重复网页、分析超链接、计算网页的重要度。

3、提供检索服务

用户输入关键词进行检索,搜索引擎从索引数据库中找到匹配该关键词的网页;为了用户便于判断,除了网页标题和URL外,还会提供一段来自网页的摘要以及其他信息。

搜索引擎的发展历史

1990年,加拿大麦吉尔大学(University of McGill)计算机学院的师生开发出Archie。当时,万维网(World Wide Web)还没有出现,人们通过FTP来共享交流资源。Archie能定期搜集并分析FTP服务器上的文件名信息,提供查找分别在各个FTP主机中的文件。用户必须输入精确的文件名进行搜索,Archie告诉用户哪个FTP服务器能下载该文件。虽然Archie搜集的信息资源不是网页(HTML文件),但和搜索引擎的基本工作方式是一样的:自动搜集信息资源、建立索引、提供检索服务。所以,Archie被公认为现代搜索引擎的鼻祖。

Robot(机器人)一词对编程者有特殊的意义。Computer Robot是指某个能以人类无法达到的不断重复执行某项任务的自动程序。由于专门用于检索信息的Robot程序象蜘蛛(spider)一样在网络间爬来爬去,因此,搜索引擎的Robot程序被称为spider程序。

1993年Matthew Gray开发了 World Wide Web Wanderer,这是第一个利用HTML网页之间的链接关系来检测万维网规模的“机器人(Robot)”程序。开始,它仅仅用来统计互联网上的服务器数量,后来也能够捕获网址(URL)。

1994年4月,斯坦福大学(Stanford University)的两名博士生,美籍华人Jerry Yang(杨致远)和David Filo共同创办了Yahoo。随着访问量和收录链接数的增长,Yahoo目录开始支持简单的数据库搜索。因为Yahoo!的数据是手工输入的,所以不能真正被归为搜索引擎,事实上只是一个可搜索的目录。雅虎于2002年12月23日收购inktomi,2003年7月14日收购包括Fast和Altavista在内的Overture,2003年11月,Yahoo全资收购3721公司。

1994年初,华盛顿大学(University of Washington )的学生Brian Pinkerton开始了他的小项目WebCrawler。1994年4月20日,WebCrawler正式亮相时仅包含来自6000个服务器的内容。WebCrawler是互联网上第一个支持搜索文件全部文字的全文搜索引擎,在它之前,用户只能通过URL和摘要搜索,摘要一般来自人工评论或程序自动取正文的前100个字。

1994年7月,卡内基·梅隆大学(Carnegie Mellon University) 的Michael Mauldin将John Leavitt的spider程序接入到其索引程序中,创建了Lycos。除了相关性排序外,Lycos还提供了前缀匹配和字符相近限制,Lycos第一个在搜索结果中使用了网页自动摘要,而最大的优势还是它远胜过其它搜索引擎的数据量。

1994年底,Infoseek正式亮相。其友善的界面,大量的附加功能,使之和Lycos一样成为搜索引擎的重要代表。

1995年,一种新的搜索引擎形式出现了——元搜索引擎(A Meta Search Engine Roundup)。用户只需提交一次搜索请求,由元搜索引擎负责转换处理,提交给多个预先选定的独立搜索引擎,并将从各独立搜索引擎返回的所有查询结果,集中起来处理后再返回给用户。第一个元搜索引擎,是Washington大学硕士生 Eric Selberg 和 Oren Etzioni 的 Metacrawler。

1995年12月,DEC的正式发布AltaVista。AltaVista是第一个支持自然语言搜索的搜索引擎,第一个实现高级搜索语法的搜索引擎(如AND, OR, NOT等)。用户可以用AltaVista搜索新闻组(Newsgroups)的内容并从互联网上获得文章,还可以搜索图片名称中的文字、搜索Titles、搜索Java applets、搜索ActiveX objects。AltaVista也声称是第一个支持用户自己向网页索引库提交或删除URL的搜索引擎,并能在24小时内上线。AltaVista最有趣的新功能之一,是搜索有链接指向某个URL的所有网站。在面向用户的界面上,AltaVista也作了大量革新。它在搜索框区域下放了“tips”以帮助用户更好的表达搜索式,这些小tip经常更新,这样,在搜索过几次以后,用户会看到很多他们可能从来不知道的的有趣功能。这系列功能,逐渐被其它搜索引擎广泛采用。1997年,AltaVista发布了一个图形演示系统LiveTopics用户从成千上万的搜索结果中找到想要的。

1995年9月26日,加州伯克利分校助教Eric Brewer、博士生Paul Gauthier创立了Inktomi,1996年5月20日,Inktomi公司成立,强大的HotBot出现在世人面前。声称每天能抓取索引1千万页,所以有远超过其它搜索引擎的新内容。HotBot也大量运用cookie储存用户的个人搜索喜好设置。

1997年8月,Northernlight搜索引擎正式现身。它曾是拥有最大数据库的搜索引擎之一,它没有Stop Words,它有出色的Current News、7,100多出版物组成的Special Collection、良好的高级搜索语法,第一个支持对搜索结果进行简单的自动分类。

1998年10月之前,Google只是斯坦福大学(Stanford University)的一个小项目BackRub。1995年博士生Larry Page开始学习搜索引擎设计,于1997年9月15日注册了google.com的域名,1997年底,在Sergey Brin和Scott Hassan、Alan Steremberg的共同参与下,BachRub开始提供Demo。1999年2月,Google完成了从Alpha版到Beta版的蜕变。Google公司则把1998年9月27日认作自己的生日。Google以网页级别(Pagerank)为基础,判断网页的重要性,使得搜索结果的相关性大大增强。Google公司的奇客(Geek)文化氛围、不作恶(Don’t be evil)的理念,为Google赢得了极高的口碑和品牌美誉。2006年4月,Google宣布其中文名称“谷歌”,这是Google第一个在非英语国家起的名字。

Fast(Alltheweb)公司创立于1997年,是挪威科技大学(NTNU)学术研究的副产品。1999年5月,发布了自己的搜索引擎AllTheWeb。Fast创立的目标是做世界上最大和最快的搜索引擎,几年来庶几近之。Fast(Alltheweb)的网页搜索可利用ODP自动分类,支持Flash和pdf搜索,支持多语言搜索,还提供新闻搜索、图像搜索、视频、MP3、和FTP搜索,拥有极其强大的高级搜索功能。(2003年2月25日,Fast的互联网搜索部门被Overture收购)。

1996年8月,sohu公司成立,制作中文网站分类目录,曾有“出门找地图,上网找搜狐”的美誉。随着互联网网站的急剧增加,这种人工编辑的分类目录已经不适应。sohu于2004年8月独立域名的搜索网站“搜狗”,自称“第三代搜索引擎”。

Openfind 创立于1998年1月,其技术源自台湾中正大学吴升教授所领导的GAIS实验室。Openfind起先只做中文搜索引擎,鼎盛时期同时为三大著名门户新浪、奇摩、雅虎提供中文搜索引擎,但2000年后市场逐渐被Baidu和Google瓜分。2002年6月,Openfind重新发布基于GAIS30 Project的Openfind搜索引擎Beta版,推出多元排序(PolyRankTM),宣布累计抓取网页35亿,开始进入英文搜索领域。

2000年1月,两位北大校友,超链分析专利发明人、前Infoseek资深工程师李彦宏与好友徐勇(加州伯克利分校博士后)在北京中关村创立了百度(Baidu)公司。2001年8月发布Baidu.com搜索引擎Beta版(此前Baidu只为其它门户网站搜狐新浪Tom等提供搜索引擎),2001年10月22日正式发布Baidu搜索引擎,专注于中文搜索。Baidu搜索引擎的其它特色包括:百度快照、网页预览/预览全部网页、相关搜索词、错别字纠正提示、mp3搜索、Flash搜索。2002年3月闪电计划(Blitzen Project)开始后,技术升级明显加快。后推出贴吧、知道、地图、国学、百科等一系列产品,深受网民欢迎。2005年8月5日在纳斯达克上市,发行价为USD 27.00,代号为BIDU。开盘价USD 66.00,以USD 122.54收盘,涨幅353.85%,创下了5年以来美国股市上市新股当日涨幅最高纪录。

2003年12月23日,原慧聪搜索正式独立运做,成立了中国搜索。2004年2月,中国搜索发布桌面搜索引擎网络猪1.0,2006年3月中搜将网络猪更名为IG(Internet Gateway)。

2005年6月,新浪正式推出自主研发的搜索引擎“爱问”。

最后,你如何评价[搜索引擎关键词快速优化]?欢迎下面互动!想了解更多精彩内容,快来关注本站吧。

推荐文章:

本文由网上采集发布,不代表我们立场,转载联系作者并注明出处:https://www.cqycseo.com/youhua/7340.html